Spis treści:

- Czy Twój sklep na PrestaShop wytrzyma Black Friday?

- Zanim zaczniesz gasić, znajdź źródło ognia

- Niezbędne narzędzia

- Poszukiwanie wąskich gardeł

- Jak stworzyć listę zadań do optymalizacji?

- Podsumowanie

Black Friday to nie tylko okazja sprzedażowa – to także test wydolności Twojego sklepu. Każdy dodatkowy moduł, każdy zapis w bazie czy log systemowy staje się wtedy realnym obciążeniem. Właśnie dlatego optymalizacja PrestaShop nie polega na „magicznych trikach” czy jednorazowych przyspieszaczach. To proces ciągły, który należy systematycznie prowadzić.

I tutaj pojawia się największy mit: wielu właścicieli sklepów uważa, że skoro raz coś zostało zoptymalizowane, to „już tak zostanie”. Tymczasem to kardynalny błąd. Aplikacja żyje i zmienia się każdego dnia – przybywa klientów, zamówień, funkcjonalności. Każda taka operacja generuje dodatkowe dane, logi czy błędy, które kumulują się w tle. Nawet jeśli dziś sklep działa płynnie, to za miesiąc lub dwa może okazać się, że gromadzone w bazie „śmieci” zaczynają realnie spowalniać procesy.

Dobrym przykładem jest wbudowana analityka PrestaShop – jeśli korzystasz z zewnętrznej (np. Google Analytics 4), wbudowana analityka Presty jest zbędnym balastem. Jej dane wypełniają tabele, przez co sklep potrzebuje coraz więcej zasobów, żeby odpowiadać na zapytania. Rozwiązanie? Lepiej je wyłączyć, a jeśli muszą zostać – zadbaj o regularne czyszczenie.

Podobnie dzieje się z logami czy zapytaniami SQL. Nie jest tak, że jeśli kiedyś były poprawiane to problem zniknął na zawsze. One generują się nieustannie – w różnych okolicznościach: przy wdrażaniu nowych modułów, przy teście płatności, a nawet podczas zwykłej obsługi klientów. Drobne błędy potrafią w początkowej fazie nie przeszkadzać, ale przy skoku ruchu (np. właśnie w Black Week) potrafią nagle sparaliżować działanie całego sklepu.

Wyobraź sobie sytuację: dodajesz nowy moduł. Wszystko działa w codziennym obciążeniu. Ale ten moduł zapisuje dane w tabeli pozbawionej indeksów. Na co dzień nie widzisz różnicy. Jednak gdy w Black Friday nagle 100 osób w tym samym momencie korzysta z koszyka – sklep dramatycznie zwalnia. I problem, którego wcześniej nie było, nagle staje się poważnym problemem.

Wniosek jest prosty: utrzymanie sklepu w dobrej kondycji jest równie ważne jak jego rozwój. Regularny przegląd, czyszczenie logów i aktualizacje to działania, które powinny być wykonywane cyklicznie. A jeśli nie robisz tego na co dzień, to absolutnym minimum jest przygotowanie się przed spodziewanym szczytem ruchu – takim jak Black Friday, święta czy kampanie promocyjne.

Dlatego pierwszym krokiem, od którego zaczniemy naszą serię artykułów, będzie audyt i diagnostyka PrestaShop. To podstawa optymalizacji – plan oparty na danych, a nie intuicji. W tym tekście pokażemy Ci, jak się do niego przygotować oraz jak krok po kroku przeprowadzić analizę wydajnościową Twojego sklepu na PrestaShop.

1. Czy Twój sklep na PrestaShop wytrzyma Black Friday?

Black Friday to czas, w którym użytkownik nie będzie miał litości dla Twojego sklepu. W normalnym okresie być może jeszcze przymknąłby oko na wolniejsze działanie, ale w szczycie zakupowym, kiedy poluje na okazje, liczy się tylko czas reakcji i niezawodność całego procesu zakupowego.

Zastanów się:

- Co się stanie, jeśli dodanie do koszyka potrwa nie 1 sekundę, a 5–10 sekund?

- Co poczuje klient, jeśli kliknie „Dodaj do koszyka” i nie zobaczy jasnego potwierdzenia, bo serwer jest przeciążony?

Odpowiedź jest prosta: opuści Twój sklep i pójdzie do konkurencji. Co gorsze, w jego głowie zostanie negatywne doświadczenie z Twoją marką. A takie emocje wracają – następnym razem klient prędzej zaufa konkurencji, niż da Ci drugą szansę.

Jak wydajność wpływa na sprzedaż?

To nie są teoretyczne rozważania. Badania jasno pokazują, że każda milisekunda ma znaczenie:

- 75% kupujących porzuca koszyk z powodu problemów z użytecznością lub zbyt wolnego działania strony, a 53% użytkowników opuszcza stronę mobilną, jeśli jej ładowanie trwa dłużej niż 3 sekundy (Google).

- Średni koszt przestoju od lat wyceniano na ok. 5600 USD za minutę, nowsze analizy podnoszą tę średnią nawet powyżej 12–14 tys. USD/min, co w dużych organizacjach sięga ok. 23,7 tys. USD/min (Gartner; Atlassian)

- 14 godzin niedostępności Facebooka w 2019 roku oszacowano na ~90 mln USD. U największych graczy każda godzina potrafi oznaczać wielomilionowe straty (Atlassian).

- Straty to nie tylko utracona sprzedaż – po złym doświadczeniu spada także zaufanie do marki, spada SEO, marnuje się płatny ruch i konwersja kampanii kierujących na uszkodzone ścieżki.

W kontekście Black Friday, gdzie w grę wchodzą często dziesiątki tysięcy złotych dziennego obrotu, te liczby stają się brutalnie realne. Wydajność = konwersja.

Optymalizacja wymaga celnej diagnozy

Instalacja modułów „przyspieszających” to najczęściej doraźny zabieg, który maskuje przyczynę problemu, zamiast ją usunąć. Warstwa cache potrafi poprawić odczuwalny czas ładowania, ale nie rozwiązuje kwestii takich jak brak indeksów w bazie, nadmiar zapytań, nadgorliwe logowanie czy ciężka logika modułów – a to właśnie te elementy decydują o stabilności pod obciążeniem Black Week.

Przykład: karta produktu ładuje się 5 s. Włączany jest full page cache i nagle widzisz 200 ms, lecz tylko wtedy, gdy treść jest serwowana z pamięci. Inwalidacja cache (aktualizacja produktu, cen, dostępności) sprawia, że czasy wracają do 5 s, a problem uderza w konwersję w kluczowym momencie. Dodatkowo, elementy dynamiczne (koszyk, personalizacja, ceny per użytkownik) wymagają bieżących danych, więc zbyt agresywne cache’owanie może wprowadzać niespójności i regresje UX.

Dlatego bez audytu wydajnościowego się nie obejdzie. Potrzebna jest diagnoza źródłowa: identyfikacja wąskich gardeł w aplikacji, bazie danych, modułach i konfiguracji serwera, a następnie priorytetyzacja zadań i działania, które utrzymają wydajność także po wygaśnięciu cache – w realnym obciążeniu Black Friday.

2. Zanim zaczniesz gasić, znajdź źródło ognia

Optymalizacja bez diagnozy to jak gaszenie pożaru bez wiedzy, skąd bierze się dym – można „lać wodę”, ale rzadko trafia się w epicentrum problemu. Audyt wydajności to rozpoznanie źródła, dzięki któremu zasoby i budżet kierowane są tam, gdzie przyniosą największy efekt w najkrótszym czasie.

Korzyści z audytu wydajności

Oszczędność czasu i budżetu

Audyt wydajności daje pełny obraz tego, co wymaga poprawy: od warstwy aplikacyjnej, przez bazę danych, po konfigurację serwera i moduły. Dzięki temu można zaplanować pracę etapami, określić priorytety i uniknąć kosztownych, przypadkowych działań, które tylko pozornie wspierają sklep. Finalnie to mniej poprawek wstecz i szybsze przełożenie na wynik biznesowy.

Bezpieczeństwo i prewencja

Audyt ujawnia problemy, które dziś nie są widoczne, ale eskalują wraz z ruchem lub przyrostem danych: np. rosnące tabele bez indeksów, powtarzalne wolne zapytania, nadgorliwe logowanie czy błędy w integracjach. Wcześnie wykryte, nie zdążą przekształcić się w krytyczne wąskie gardła podczas Black Week.

Mierzalne rezultaty

Audyt wyznacza punkt „przed” i „po”, więc efekty optymalizacji można zweryfikować metrykami: czasy odpowiedzi kontrolerów, liczba i koszt zapytań SQL, TTFB, LCP/TBT, obciążenie CPU/RAM czy skuteczność cache. To twardy dowód, że wdrożone zmiany poprawiły wydajność i stabilność ścieżek krytycznych (koszyk, checkout, karta produktu).

3. Niezbędne narzędzia

Audytu nie da się przeprowadzić w ciemno – potrzebne są narzędzia, które pokażą, gdzie faktycznie ucieka czas i zasoby. Optymalizacja wydajności to proces, nie jednorazowa akcja: aplikacja się zmienia, przybywa danych, dochodzą moduły i integracje, więc monitoring ciągły jest tak samo ważny jak audyt punktowy przed Black Friday. Jeśli problemy się nawarstwiają, serwis może przestać odpowiadać przy skoku ruchu.

- Zestaw podstawowy: narzędzia dostępne od ręki, pozwalające szybko wyłapać oczywiste wąskie gardła (profilery, logi, inspekcja zapytań, metryki czasu odpowiedzi).

- Zestaw zaawansowany: rozwiązania monitorujące 24/7, które alarmują o spadkach wydajności i błędach w czasie rzeczywistym oraz pozwalają odtworzyć pełną ścieżkę problemu.

- Kluczowe założenie: najpierw diagnoza i dane, potem priorytety i plan prac – nie odwrotnie.

Profiler w PrestaShop (must‑have)

W PrestaShop są dostępne wbudowane profilery, które pozwalają przeanalizować wydajność na froncie i w back office. To pierwsze narzędzie, które warto uruchomić przy audycie – daje szybki, wiarygodny obraz sytuacji bez instalowania dodatkowych komponentów.

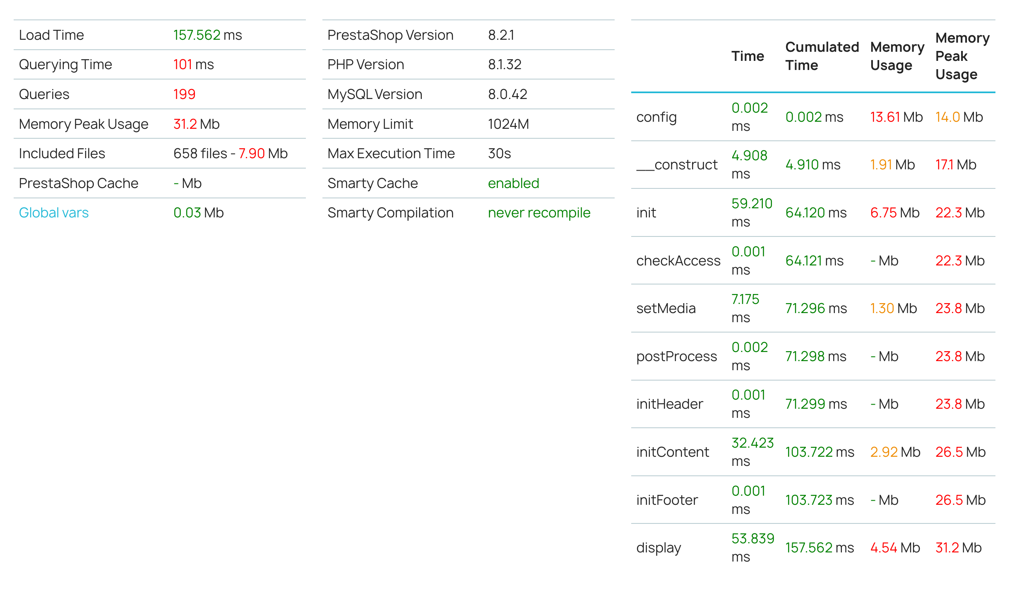

Co mierzy profiler frontu (PrestaShop)

- Czasy operacji i zużycie pamięci w cyklu życia kontrolera.

- Liczbę i łączny czas zapytań SQL, duplikacje zapytań, najczęściej odpytywane tabele.

- Konfigurację cache i kompilacji szablonów (Smarty), ustawienia PHP/MySQL (limity czasu i pamięci).

Co mierzy profiler w back office (PrestaShop + Symfony)

- Szczegółowe dane o każdym żądaniu w panelu: zapytania SQL, logi, eventy, formularze, hooki i czas renderowania.

- Ułatwia wyłapanie wolnych operacji administracyjnych, które potrafią pośrednio spowalniać front (np. zbyt ciężkie CRON‑y, nieoptymalne integracje).

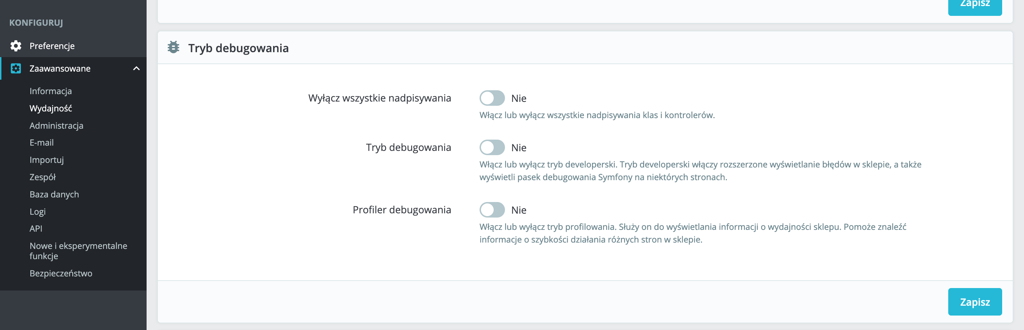

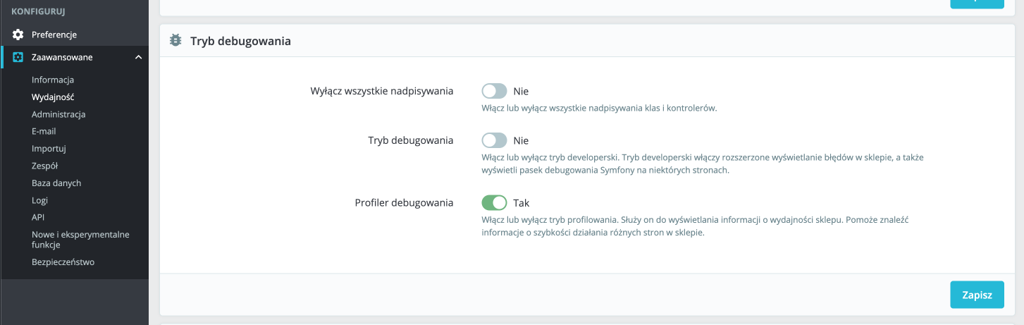

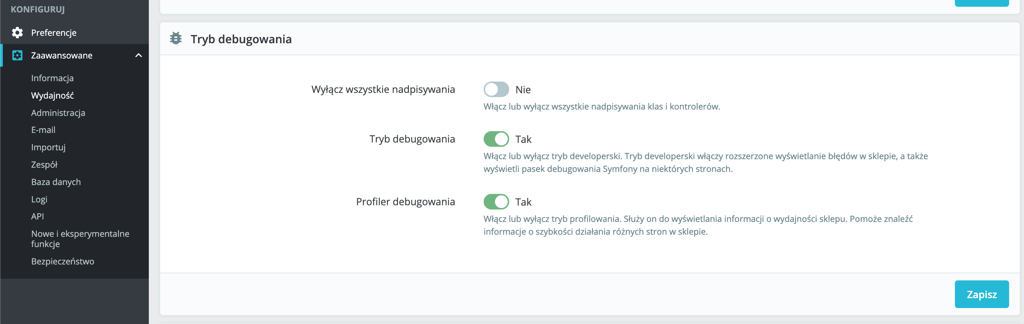

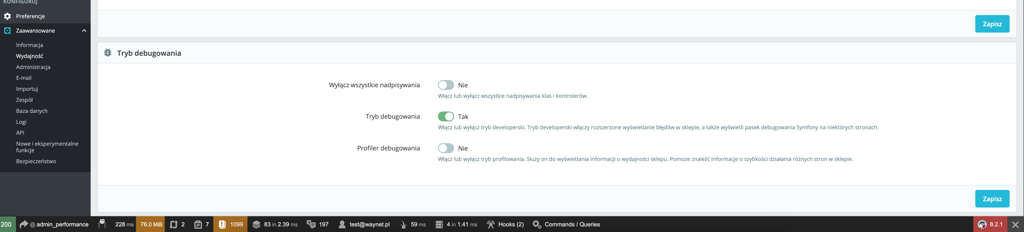

Jak włączyć?

Przejdź do panelu administracyjnego → Zaawansowane → Wydajność.

W sekcji Tryb debugowania znajdź Profiler debugowania, włącz i zapisz.

Od teraz profiler będzie aktywny zarówno na froncie, jak i w panelu administracyjnym.

Aby uruchomić profiler Symfony w Back Office, w tej samej zakładce włącz Tryb debugowania (jeśli nie był jeszcze włączony).

Od tego momentu profiler działa w BO i na froncie. Aby uruchomić profiler Symfony w BO, włącz również Tryb debugowania w tej samej zakładce.

Uwaga: Nie uruchamiaj profilera ani trybu debugowania na aktywnej produkcji w trakcie sprzedaży – zwiększają obciążenie, eksponują dane i mogą pogorszyć czasy odpowiedzi. Najlepiej używać stagingu lub wykonywać pomiary poza szczytem.

Profiler autorski PrestaShop

Panel profilera jest surowy, ale przejrzysty – daje wgląd w kluczowe metryki i konfiguracje:

- Czas załadowania aplikacji i rozbicie na etapy – szybka diagnoza, w którym momencie spędzany jest największy czas.

- Zapytania do bazy: łączny czas i ilość, a także duplikacje – identyfikacja wzorców N+1 i miejsc bez indeksów.

- Zużycie RAM w trakcie działania – graniczne użycie pamięci bywa ukrytym winowajcą.

- Parametry serwera: wersja PHP, MySQL, limit RAM na operację, maksymalny czas wykonania – często to one stanowią „szklaną sufitę” wydajności.

- Cache i kompilacja Smarty – czy konfiguracja nie wymusza zbędnych rekompilacji, czy cache działa zgodnie z założeniem.

- Zakładka z czasami operacji oraz zużyciem RAM w cyklu życia aplikacji – ułatwia „trafienie” w newralgiczny etap.

Główny panel profilera dostarcza nam najważniejsze informacje i metryki na temat wydajności naszej aplikacji.

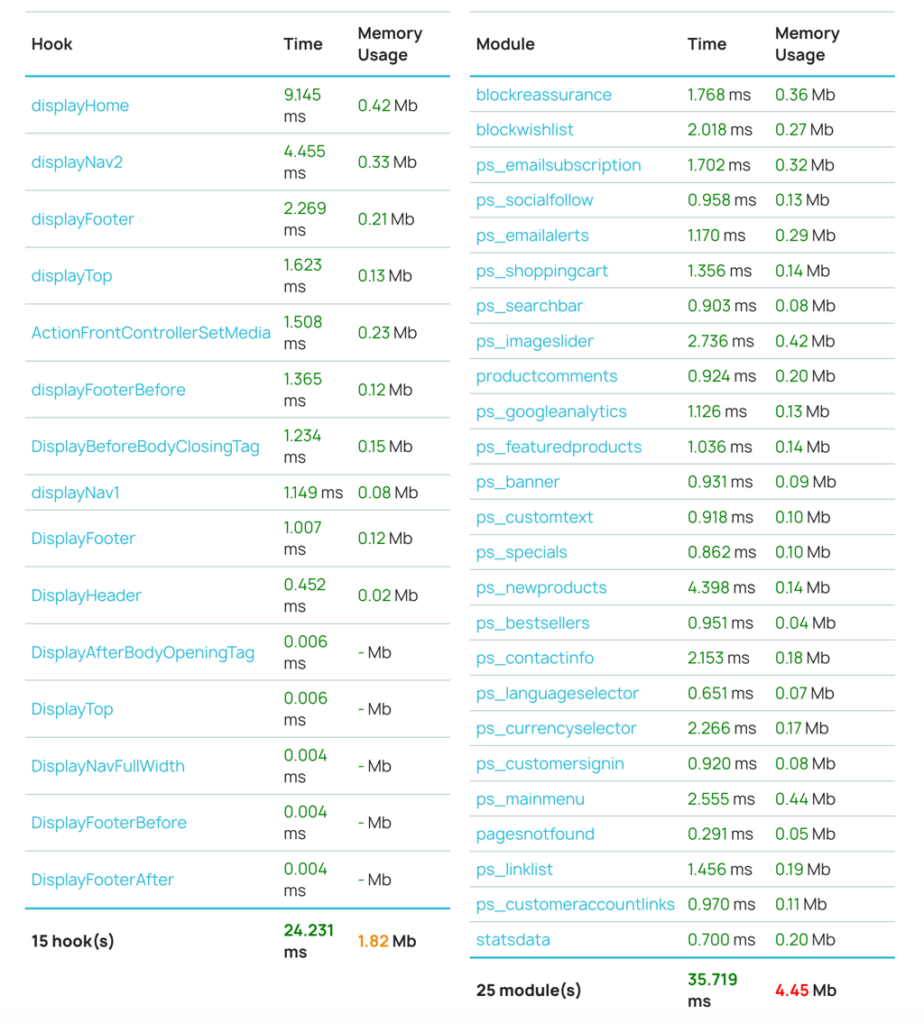

Najczęstsze źródła problemów to moduły firm trzecich i konkretne hooki. Dedykowany panel pozwala sprawdzić czasy wykonywania modułów w danym hooku oraz zużycie pamięci – to idealna mapa „kandydatów do optymalizacji/wyłączenia”.

Lista czasów wykonywania poszczególnych hooków i modułów jest zwykle najważniejszym źródłem informacji – to właśnie tutaj znajdzie się około 90% problemów wydajnościowych. Rdzeń PrestaShop jest dobrze zoptymalizowany i z reguły nie powinien powodować istotnych kłopotów z wydajnością.

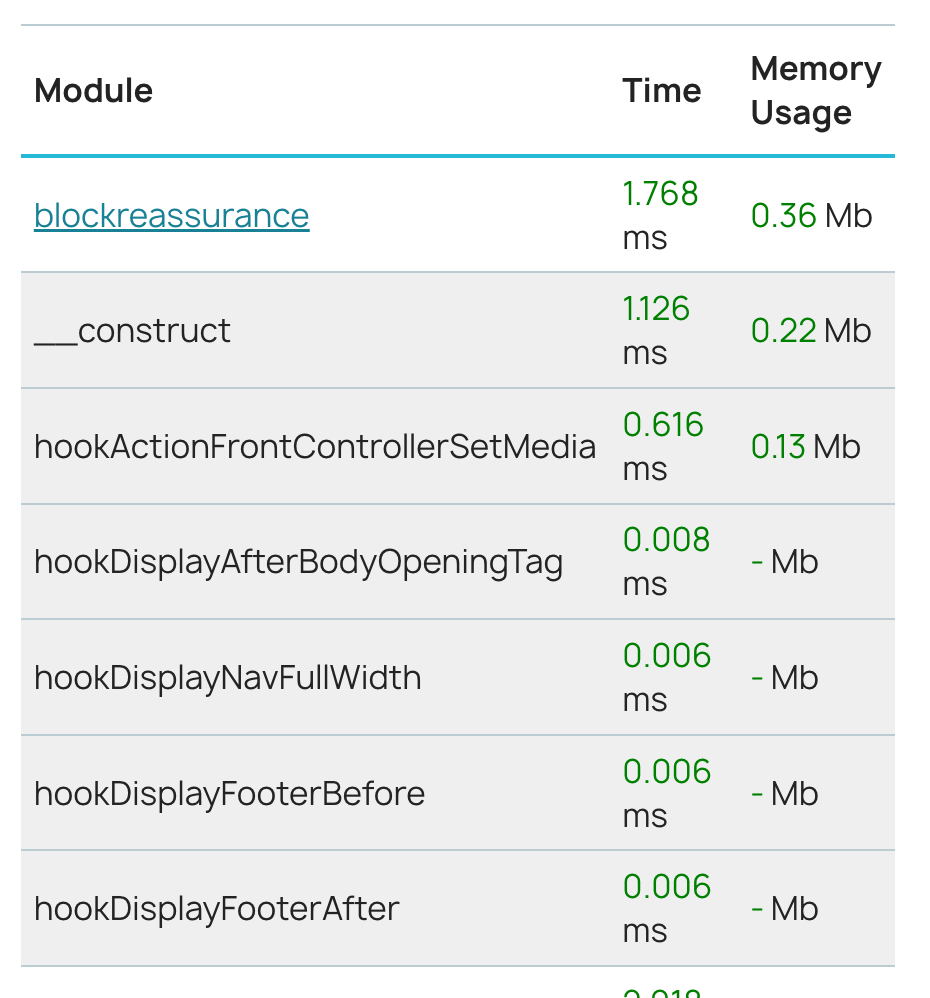

W module blockreassurance (Bezpieczeństwo klienta) widać łączny czas oraz zużycie pamięci RAM. Jeśli jednak problem dotyczy tylko jednego hooka wywoływanego przez ten moduł, warto skorzystać z bardziej szczegółowych danych, aby łatwiej zlokalizować źródło kłopotu.

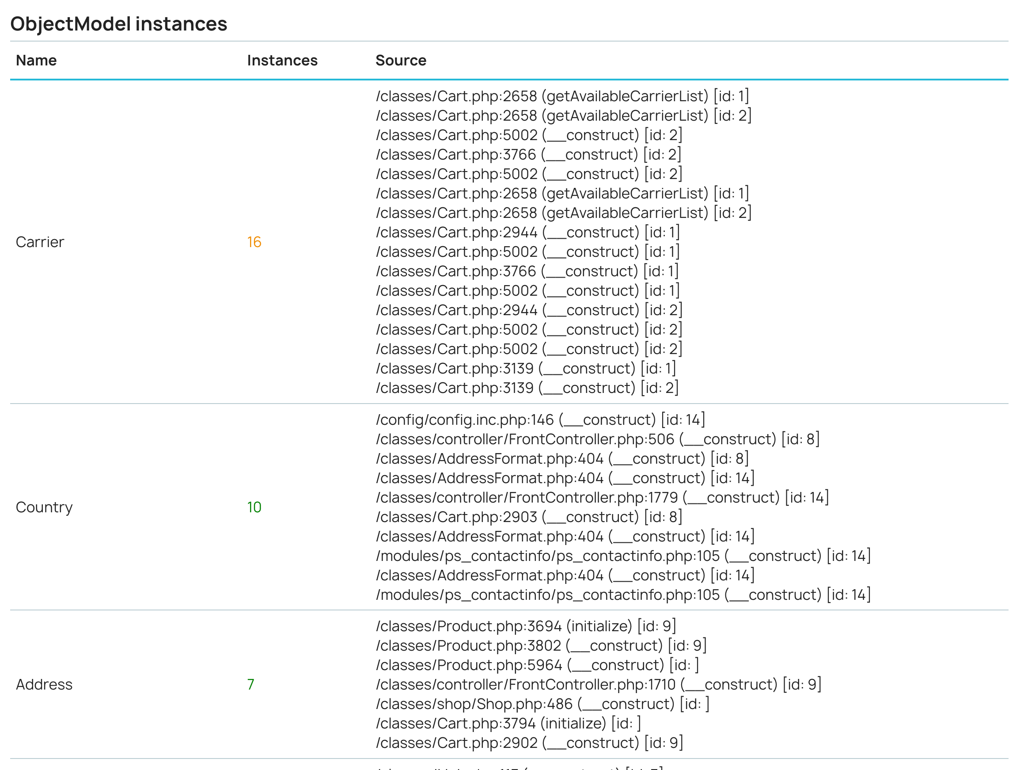

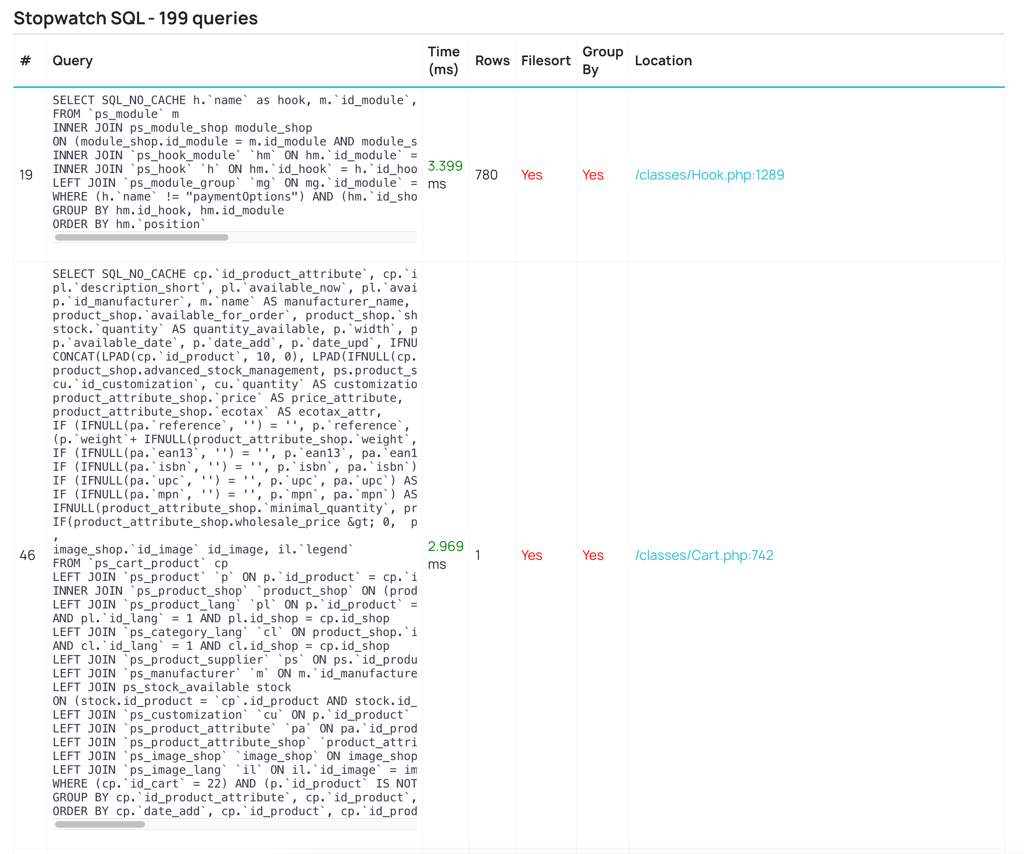

Dodatkowo profiler umożliwia wgląd w wykonane zapytania SQL, ich duplikacje, najczęściej odpytywane tabele oraz liczbę instancji ObjectModeli – to materiał do pracy nad indeksami, ograniczeniem powtarzalnych zapytań i poprawą modelu danych.

Najczęściej inicjalizowanym ObjectModelem w tej tabeli jest Carrier, który – jak wskazuje kolumna source – tworzony jest głównie w klasie Cart. Jeśli widać tutaj wyraźny przyrost dla któregokolwiek z ObjectModeli, przeanalizuj, czy instancji nie da się zbuforować w pamięci.

Najczęściej odpytywanymi tabelami są modules oraz module_shop, powiązane z modułami w sklepie. Jeżeli zapytania są szybkie dzięki poprawnym indeksom, nie powinno to stanowić problemu. Gdy jednak obciążenie rośnie lub czasy zaczynają się wydłużać, warto wrócić do analizy i zweryfikować potencjalne wąskie gardła.

Widzimy przykładowo zapytanie o dostępne hooki dla modułów, które w tym przebiegu dotyka 780 rekordów w bazie. Dodatkowo dostępny jest stack trace tego zapytania, co ułatwia precyzyjną lokalizację źródła wywołania i zawężenie obszaru analizy.

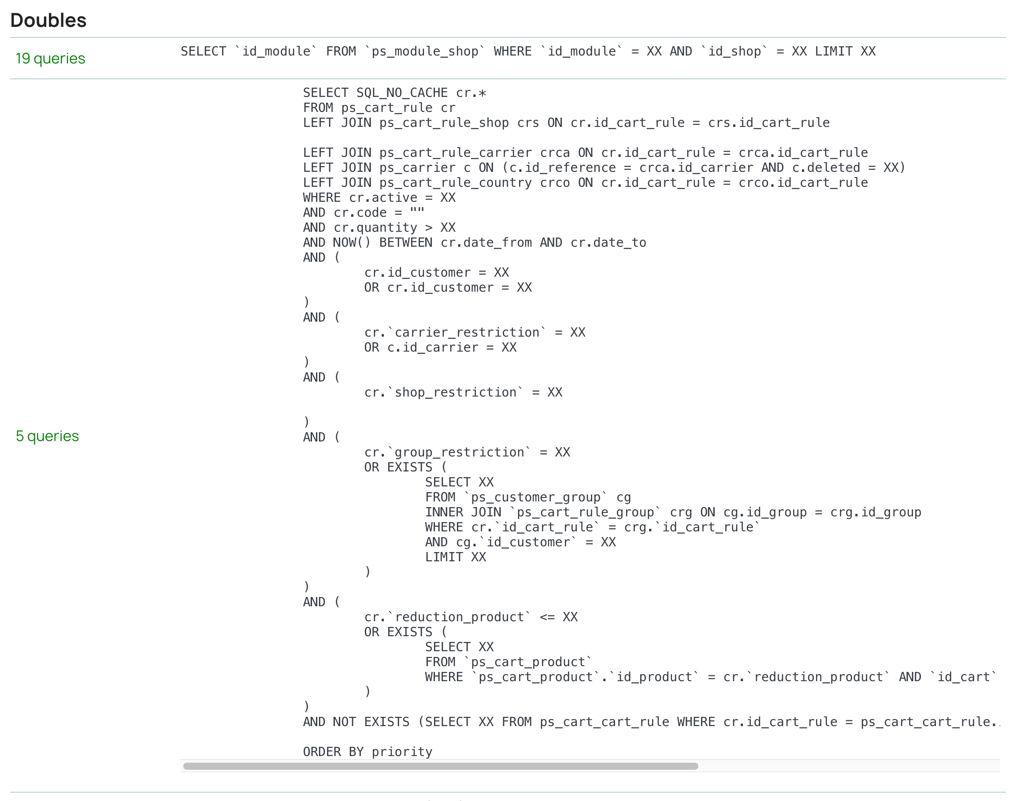

Proste zapytanie po id_module wykonywane jest 19 razy. Na pierwszy rzut oka może nie wyglądać to groźnie, ale bez monitoringu skala z czasem może narastać. Rozważ statyczny cache w kodzie lub cache obiektowy (np. memcached/Redis) dla zduplikowanych zapytań.

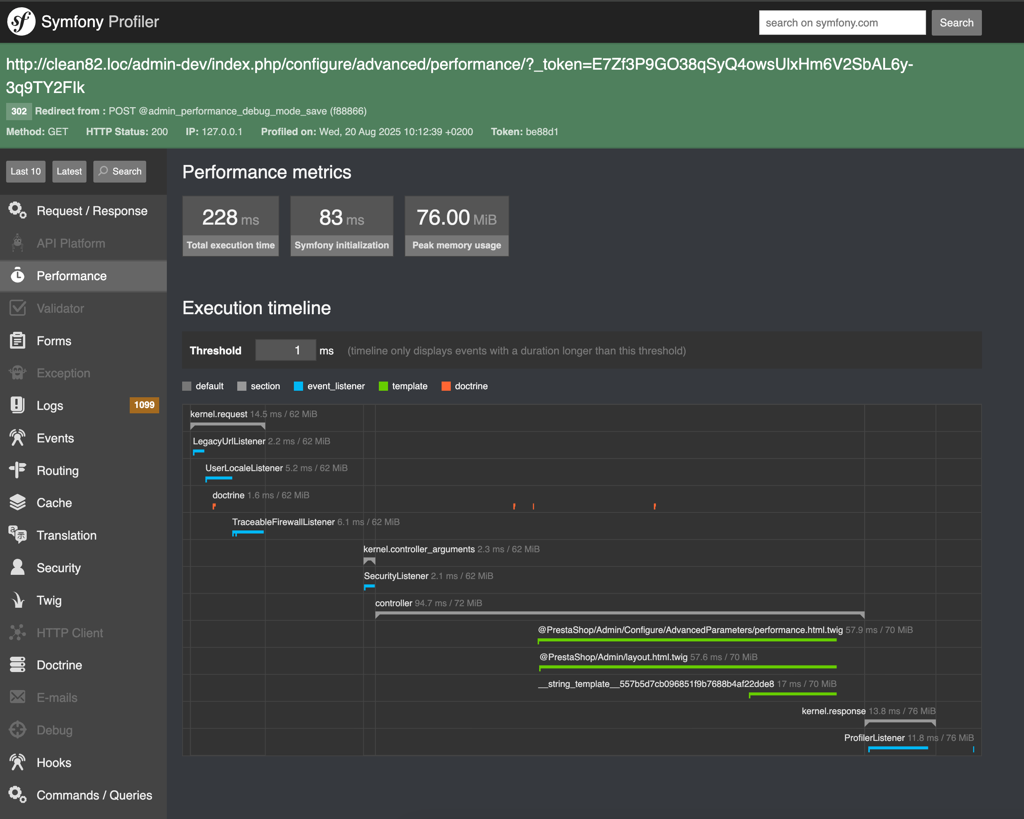

Profiler Symfony

Po włączeniu trybu debugowania w panelu administracyjnym pojawi się pasek profilera Symfony (na dole ekranu).

To narzędzie pozwala przeanalizować każde żądanie BO z pełnym kontekstem.

- Dostępne „dashboardy” i panele: wydajnościowy, logi aplikacji, eventy, dane formularzy, zapytania do bazy, wykonane hooki i inne.

- Zastosowanie: diagnoza wolnych operacji BO (np. zapis produktu), weryfikacja integracji spowalniających panel (ERP/PIM/marketplace), wpływ obciążenia BO (CRON, kolejki) na ogólną kondycję systemu.

Jak pracować z danymi z profilera (esencja interpretacji)

- Identyfikuj sekcje z największym udziałem w czasie całkowitym: kontroler, hook, moduł – to naturalne cele optymalizacji.

- W SQL wyłapuj zapytania > 500 ms, duplikacje (N+1), brakujące indeksy oraz ciężkie JOIN‑y na dużych tabelach.

- Notuj, które hooki i moduły generują najwyższe koszty – rozważ refaktor, lazy‑load, warunkowe wywołanie lub nawet czasowe wyłączenie.

- Korelacja to podstawa: zestawiaj wnioski z profilera z logami aplikacji i serwera oraz metrykami infrastruktury (CPU, RAM, I/O, sieć) – to pomaga potwierdzić, czy wąskie gardło leży w kodzie, bazie, czy na maszynie.

Wskazówka: Przygotuj powtarzalne scenariusze testowe (kategoria → produkt → koszyk → checkout → logowanie/panel) i wykonuj je w tych samych warunkach, by wyniki były porównywalne między iteracjami. Jeśli to możliwe, wyłącz zbędne moduły w trakcie pomiarów, by ograniczyć szum.

Monitoring zaawansowany

Jeżeli sklep działa intensywnie i jest istotny biznesowo, rozważ wdrożenie profilowania/monitoringu 24/7. Tego typu narzędzia działają w modelu SaaS i automatycznie wykrywają problemy wydajnościowe oraz błędy aplikacji, a także alarmują zespół, zanim sytuacja stanie się krytyczna.

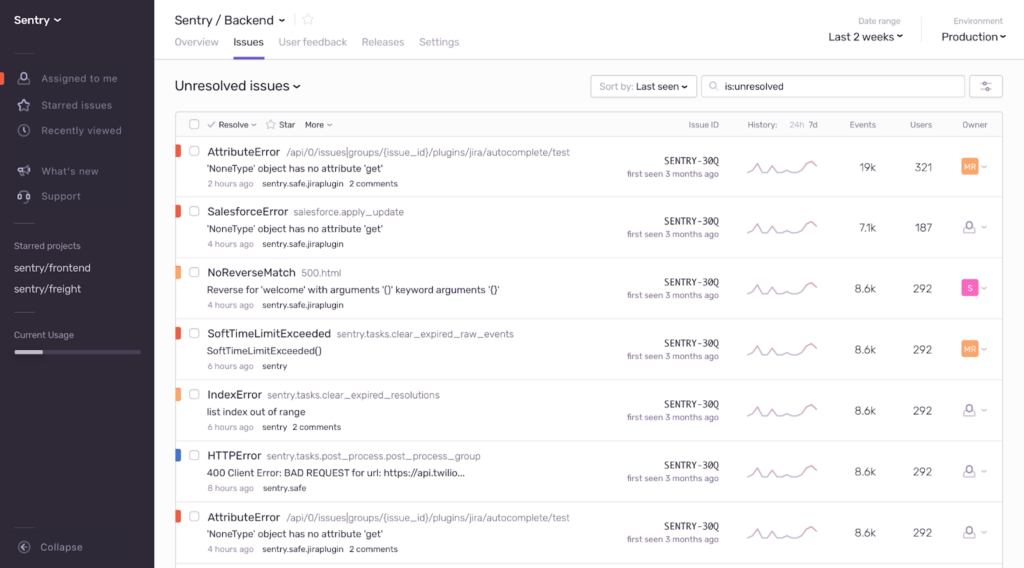

- Sentry – pełnoprawny APM: monitoruje wydajność (transakcje i czasy), wykrywa błędy z pełnym kontekstem (stack trace, breadcrumbs), oferuje nagrywanie sesji i alerty; często traktowany jako standard branżowy.

- Datadog – rozbudowany monitoring APM/infrastruktury, korelacja usług, metryki, logi i ślady (traces).

- New Relic – kompleksowe APM, transakcje, segmentacja czasu, analiza zależności, SLA i alerting.

APM (ang. Application Performance Monitoring) pokazuje dokładne informacje o wydajności, lokalizuje problemy w transakcjach (np. zapis zamówienia, płatność), i obrazuje pełną ścieżkę momentu, w którym wystąpił problem. Alerty przyspieszają reakcję i skracają czas naprawy (MTTR).

Panel Senty

Ważne: wdrożenie każdego z tych rozwiązań wymaga wsparcia developera (instalacja, konfiguracja, ewentualne znaczniki w kodzie). W zamian otrzymuje się ciągłą widoczność kondycji sklepu, co minimalizuje ryzyko niespodzianek w trakcie Black Week.

4. Poszukiwanie wąskich gardeł

Wąskie gardło (ang. bottleneck) to element procesu, który ogranicza przepustowość całego systemu – najwolniejszy etap determinuje maksymalną szybkość działania sklepu. W e‑commerce może to być zapytanie SQL, moduł w konkretnym hooku, proces w BO, blokada I/O, a nawet wyciek pamięci. Klucz to zlokalizować miejsce, w którym czas „rozpływa się” najszybciej, a następnie zmierzyć wpływ jego optymalizacji.

Dlaczego to ważne?

- Optymalizacja elementu, który nie jest wąskim gardłem, nie poprawi realnej wydajności ścieżek krytycznych.

- Z kolei trafiona optymalizacja wąskiego gardła zwiększa przepustowość całego procesu, szczególnie w Black Week.

Zapytanie do bazy i slow logi

Baza danych utrzymuje stan całej aplikacji. Wolne zapytania są widoczne na froncie i w BO – spowalniają koszyk, checkout, listy produktów, panel użytkownika, a także operacje administracyjne.

Czym są slow logi

Slow log to dziennik zapytań przekraczających ustalony czas (np. > 500 ms). Daje listę realnych kandydatów do optymalizacji – zamiast zgadywać, pracujesz na twardych danych.

Jak sprawdzić slow logi?

Aby uruchomić slow logi dla zapytań MySQL najlepiej skontaktuj się z administratorem twojego serwera.

Czego szukać w pierwszej kolejności

- Długich i powtarzalnych zapytań (częstotliwość × koszt = realny wpływ).

- Operacji związanych z koszykiem, dostępnością, ceną, atrybutami – to zwykle najbardziej obciążone obszary.

- Zapytania, które „wybuchają” dopiero przy większej liczbie rekordów (np. bez indeksów po kilku miesiącach danych).

Nadgorliwe logowanie (Over-logging)

Każdy zapis do logów to operacja na dysku lub na bazie – w skali ruchu rośnie koszt I/O i blokady. W PrestaShop dodatkowo logi mogą trafiać do tabeli prefix_log, co powiększa bazę, utrudnia porównania i spowalnia operacje.

Jak sprawdzić Over-logging

- Poproś administratora o wyciąg z logów serwera (aplikacja, PHP, www, baza, reverse proxy).

- Sprawdź w bazie tabelę prefix_log: rozmiar, liczbę wpisów, powtarzalność komunikatów.

- Zbierz przykłady notice/warning/deprecation – często generują ogromny szum.

Czego szukać

- Powtarzalnych ostrzeżeń i deprecation (łatwe punkty do wyciszenia/usunięcia u źródła).

- Zdarzeń logowanych w pętli lub przy każdym żądaniu, które nie wnoszą wartości.

- Sytuacji, w których włączona jest deduplikacja logów, ale porównania dużej tabeli same stają się kosztowne.

Działania naprawcze

- Ogranicz poziom logowania na produkcji (INFO/NOTICE tylko, gdy to konieczne).

- Czyść lub archiwizuj prefix_log (z zachowaniem polityki retencji).

- Napraw źródłowe przyczyny ostrzeżeń i błędów (to zwykle szybki „win” wydajności).

Ważne: Nadmiar logów to nie tylko koszt wydajności – to także szum diagnostyczny, który utrudnia zauważenie faktycznych problemów w piku.

Testy w realnych warunkach

Szybka strona główna nie oznacza szybkiego sklepu. Wydajność często załamuje się tam, gdzie jest najwięcej logiki biznesowej – w koszyku, checkoutcie, panelu użytkownika, przy filtrowaniu czy wyszukiwaniu.

Przykładowe scenariusze, które warto przejść z włączonym profilterem:

- Dodaj > 10 unikalnych SKU do koszyka – obserwuj czasy w zależności od liczby pozycji.

- Dodaj produkty do ulubionych – sprawdź, czy liczba elementów nie degraduje widoku.

- Przejdź całą ścieżkę zakupową – od koszyka po płatność (kontroluj czasy przejść).

- Sprawdź panel użytkownika – widok zamówień vs. liczba zamówień, liczba adresów, historię.

- Wykonaj wyszukiwanie i filtrowanie produktów – obserwuj czasy odpowiedzi i zapytania SQL.

Dobre praktyki

- Powtarzalność: te same kroki, podobne dane, kontrolowane warunki.

- Notuj pomiary: czas całkowity, TTFB, liczba/łączny czas SQL, największy udział modułów/hooków.

- Izoluj zmienne: tymczasowo wyłącz zbędne moduły, by wyraźniej zobaczyć „winowajców”.

Diagnostyka vs. Testy obciążeniowe

Ręczne „przeklikiwanie” sklepu i analiza w profilerze są kluczowe do diagnozowania problemów w pojedynczych procesach – pozwalają wskazać, gdzie dokładnie tracony jest czas i co należy poprawić u źródła na konkretnej ścieżce (np. koszyk, checkout, wyszukiwanie). To jednak nie odpowie na pytanie: czy środowisko wytrzyma, gdy w tej samej minucie spróbuje kupować 100 osób.

Do oceny odporności na szczyty ruchu służą zautomatyzowane testy obciążeniowe (tzw. swarming). Pozwalają symulować masowy, równoczesny ruch i sprawdzić zachowanie całego stosu: aplikacji, bazy danych, cache, serwera, sieci. Do takich testów używa się narzędzi klasy Locust, Gatling czy k6 – dzięki nim można modelować realistyczne scenariusze (profile użytkowników, rozkład akcji, czasy między kliknięciami) i mierzyć czasy odpowiedzi, błędy 5xx, limity zasobów oraz punkty nasycenia.

To absolutnie kluczowy etap weryfikacji gotowości sklepu na Black Friday: najpierw diagnoza wąskich gardeł (profiler, logi, slow logi, scenariusze funkcjonalne) i poprawki u źródła, a następnie testy obciążeniowe, które walidują całość pod presją realnego, równoległego ruchu. W tej serii poświęcimy tym testom osobny artykuł.

5. Jak stworzyć listę zadań do optymalizacji?

Audyt bez listy zadań kończy się raportem do szuflady. Lista zadań (backlog optymalizacyjny) zamienia wnioski z diagnozy na konkretne działania, z priorytetem, kontekstem odtworzenia i metryką sukcesu. Dzięki temu zespół wie, co robić najpierw, a interesariusze mogą rozliczyć efekty „przed/po”. Najważniejsze, by każdy wpis był jednoznaczny, odtwarzalny i mierzalny.

Co powinna zawierać dobra lista zadań

- Problem – opis objawu w języku użytkowym i technicznym.

- Kiedy występuje – warunki odtworzenia (ścieżka, liczba SKU, profil użytkownika, pora, typ ruchu).

- Priorytet – wartość biznesowa × złożoność wdrożenia × ryzyko.

- Sugerowane działanie – kierunek naprawy (bez przepisywania rozwiązania, jeśli odbiorcą jest nietechniczny).

- Dodatkowo: metryka bazowa (przed), cel (po), właściciel, termin, zależności.

Jak ustalić priorytet

- Wysoki: wpływa na koszyk/checkout lub generuje duży koszt przy dużej częstotliwości (np. wolne, powtarzalne zapytania SQL), niski/średni koszt wdrożenia, wysoka pewność efektu.

- Średni: poprawia często używaną ścieżkę, ale efekt jest pośredni lub wdrożenie wymaga koordynacji wielu komponentów.

- Niski: rzadko występujący przypadek, kosmetyka wydajnościowa, refaktor o niepewnym zysku.

Tip: Jeśli audyt prowadzi osoba nietechniczna, priorytet może pomóc ustalić developer/architekt, bo często „mały fix” (np. indeks na kolumnie) daje duży efekt przy niskim koszcie – to tzw. quick wins.

Przykładowa tabela zadań

| Problem | Kiedy występuje | Priorytet | Sugerowanie działanie |

| Długi czas ładowania koszyka (>3s) | Gdy w koszyku znajduje się ponad 15 unikalnych produktów. Inne informacje pozwalające odtworzyć problem. | Wysoki | Lokalizacja źródła problemu ale bez podawania rozwiązania do problemu. W zależności od tego kto wykonuje audyt wydajnościowy, to pole może zawierać mniej lub bardziej techniczne informacje. |

Wskazówka: do każdej pozycji dopisz metrykę bazową (np. „czas koszyka: 3,8 s P95”), cel (np. „≤1,5 s P95”), sposób pomiaru (profiler/monitoring) i termin. Dzięki temu łatwo raportować postęp.

Jak stworzyć tę listę w praktyce (krok po kroku)

- Zbierz materiał z audytu: screeny z profilera, listy najcięższych hooków/modułów, slow logi, logi aplikacji, notatki z scenariuszy testowych.

- Zgrupuj problemy według ścieżek krytycznych: PDP, koszyk, checkout, wyszukiwanie/filtry, panel użytkownika, BO.

- Dla każdej ścieżki wybierz maksymalnie 3–5 największych wąskich gardeł (zasada Pareto).

- Oszacuj wpływ biznesowy (częstotliwość × dotkliwość) i koszt wdrożenia (czas/ryzyko/zależności).

- Nadaj priorytety, przypisz właścicieli i terminy.

- Zdefiniuj metryki sukcesu (P75/P95 czasu odpowiedzi, łączny czas SQL, liczba zapytań, TTFB/LCP/TBT).

- Wdrażaj iteracyjnie: małe paczki zmian + pomiar “przed” i „po”, żeby szybko potwierdzać efekt i korygować plan.

Podsumowanie

Black Friday bezlitośnie weryfikuje jakość zaplecza technicznego. Zamiast szukać „magicznych przyspieszaczy”, postaw na audyt oparty na danych: profiler PrestaShop (front i BO), slow logi SQL, logi aplikacji i serwera oraz scenariusze testowe na ścieżkach krytycznych (PDP, koszyk, checkout, wyszukiwanie, panel użytkownika). To dzięki nim precyzyjnie widać, gdzie naprawdę ucieka czas i zasoby.

Utrzymanie wydajności to ciągły proces, nie jednorazowa akcja. Aplikacja żyje, rosną dane, dochodzą moduły i integracje – dlatego obok audytu punktowego potrzebny jest monitoring 24/7, iteracyjne porządki oraz jasna lista priorytetów, która zamienia wnioski w konkretne zadania. Często małe i celne poprawki (indeksy, eliminacja N+1, higiena logów, refaktor kosztownych hooków) przynoszą największy efekt przy rozsądnym nakładzie pracy.

W kolejnym artykule przejdziemy od diagnozy do działania: pokażemy fundamenty optymalizacji aplikacji PrestaShop – konfigurację kompilacji i cache, porządek w modułach i hookach, wskazówki dla warstwy kodu i szablonów oraz przygotowanie gruntu pod dalsze etapy (baza danych, serwer, CDN, Varnish, bezpieczeństwo i testy obciążeniowe).

Jeśli potrzebujesz wsparcia przy optymalizacji swojego sklepu na PrestaShop lub po prostu chcesz porozmawiać o rozwoju – skontaktuj się z nami.